Uwaga! Ta strona służy popularyzacji rachunku prawdopodobieństwa przez przedstawienie go jako owocu zakazanego. Autor nie czuje się odpowiedzialny za jakiekolwiek próby zastosowania niżej przedstawionych recept w celu uzyskania korzyści materialnych.

Jak się wzbogacić prawie na pewno?

Tytułem komentarza: We współczesnym rachunku prawdopodobieństwa mówi się, że zdarzenie \(A\) zachodzi prawie na pewno wtedy i tylko wtedy, gdy prawdopodobieństwo \(A\) wynosi \(1\); \(P(A)=1\) bądź równoważnie \(P(\text{nie }A)=0\). Nie znaczy to bynajmniej, że niezajście \(A\) jest niemożliwe. W częstościowej interpretacji prawdopodobieństwa (von Mises 1919) \(P(\text{nie }A)=0\) oznacza po prostu, że stosunek liczby eksperymentów, w których \(A\) nie zaszło, do liczby wszystkich eksperymentów dąży do \(0\) przy liczbie eksperymentów dążącej do nieskończoności. Jeżeli \(P(\text{nie }A)=0\), to nie-\(A\) może się zdarzyć nawet nieskończenie wiele razy.

Jak zrujnować kasyno, czyli martyngały

Pamiętam, jak na pewnej niezobowiązującej letniej szkole, w której uczestniczyłem jako student fizyki, urządzono nam krótki półgodzinny wstęp do nowoczesnej teorii rachunku prawdopodobieństwa z sigma-ciałami i martyngałami (Billingsley 1979). Wykład był na tyle suchy, że w znacznej mierze zignorowałem go pomimo pewnego zaintrygowania i niepokoju, jakie pojęcie prawdopodobieństwa we mnie budziło już wtedy. Dopiero po kilku latach dowiedziałem się, że martyngał to nazwa pewnej bardzo ciekawej i bezpiecznej strategii zarobienia dowolnie dużej ilości pieniędzy.

Niestety martyngał można zastosować wyłącznie w pewnych specyficznych warunkach. Po pierwsze, musimy mieć bogatego wujka, u którego możemy zaciągnąć w dowolnej chwili dowolnie wysoki nieoprocentowany kredyt (bez obaw, spłacimy go). Po drugie, musi istnieć kasyno, które nigdy nie splajtuje i w którym niezależnie od naszego kapitału będziemy mogli grać po wsze czasy w następującą grę uchodzącą w powszechnej opinii za uczciwą dla obu stron:

W każdej turze gry pracownik kasyna rzuca uczciwą monetą, tzn. wypadać mogą wyłącznie orzeł i reszka z równą graniczną częstością.

- Jeżeli przed turą wpłacimy do kasyna \(N\) złotych, to kasyno wypłaca nam \(2N\) złotych, jeśli wypadnie reszka.

- Jeśli wypadnie orzeł, kasyno nie wypłaca nam nic.

Zakłada się, że niezależnie od naszego salda możemy zdecydować sami, czy w danej turze uczestniczymy, czy też nie.

Strategia martyngału przedstawia się następująco:

- Niezależnie od naszych dotychczasowych osiągnięć, w każdej turze podwajamy stawkę (tzn. z pomocą wujka wpłacamy do kasyna \(2^{M-1}\) złotych w \(M\)-tej turze).

Zauważmy, że jeżeli w K-tej turze wypadnie reszka, to związana z nią wypłata (\(2^K\) złotych) pokryje wszystkie wcześniejsze wpłaty (\(1 + 2 + ... + 2^{K-1} = 2^K-1\) złotych). Ewentualne wcześniejsze wypłaty są naszym czystym zyskiem, którego wujkowi oddawać nie musimy. Wniosek nasuwa się sam: Zaciągamy kredyt tak długo, aż reszka wypadnie dostatecznie wiele razy, abyśmy zgromadzili pewną z góry upatrzoną kwotę. Po wypadnięciu upragnionej reszki odbieramy wypłatę, odstępujemy od gry, spłacamy wujka, a za resztę hulamy...

Prawdopodobieństwo tego, że w nieskończonym ciągu rzutów reszka wypadnie tylko skończenie wiele razy wynosi \(0\) (Billingsley 1979). Z tego powodu strategia martyngału gwarantuje, że możemy się wzbogacić prawie na pewno w skończonym czasie o dowolną skończoną kwotę.

Linki

- Gambler's Ruin (mathworld.wolfram.com)

- Martingale (mathworld.wolfram.com)

Jak oszukiwać fiskusa, czyli prawo Benforda

W ramach szkodzenia współobywatelom urzędy podatkowe można oszukiwać na różne sposoby. Sprytniejsze sposoby zapewne wymagają dobrej znajomości reguł księgowania i kruczków prawa podatkowego (brrr...). Osoby mniej rozgarnięte posuwają się do wysysania kwot umieszczanych w formularzach z palca. Niestety zmyślanie wiarygodnych liczb jest czynnością, która wymaga nadspodziewanie wiele myślenia.

Frank Benford (fizyk) badał swego czasu rozkład częstości cyfr pojawiających się w tablicach danych geograficznych i gospodarczych, a także w tablicach stałych fizycznych i matematycznych. Stwierdził on, że rozkład wartości pierwszej cyfry znaczącej dla liczb z tych tablic silnie odbiega od rozkładu jednostajnego (Benford 1938). W idealnym przypadku rozkład wartości tejże cyfry opisywany jest tak zwanym prawem Benforda.

Fama głosi, że prawo Benforda obowiązuje nie tylko dla danych przyrodniczych, ale także dla niesfałszowanych danych księgowych i podatkowych. Dla danych sfałszowanych pojawiają się odstępstwa w stronę rozkładu równomiernego. Niestety niektórzy statystycy zakładają ostatnio firmy konsultingowe zajmujące się wykrywaniem tego rodzaju fałszerstw, a zatem można się spodziewać, że w przyszłości dane podatkowe będą fałszowane w taki sposób, aby prawo Benforda także spełniały.

Źródłem uniwersalności prawa Benforda jest to, że nasz sposób mierzenia stałych naturalnych i ich symbolicznego reprezentowania (za pomocą cyfr) jest w znacznej mierze arbitralny. Weźmy sobie jakąś długą listę liczb rzeczywistych pochodzących z pomiarów eksperymentalnych:

(\(r_1\) = wysokość Mt. Everestu w metrach, \(r_2\) = głębokość Śniardw w calach, \(r_3\) = masa cukru sprzedanego w Burkina Faso w troy-uncjach, \(r_4\) = liczba pi, ..., \(r_N\) = suma długości wszyskich kanap w Santa Fe Institute w milimetrach). Spodziewamy się, że rozkład częstości cyfr na pozycjach liczonych od najbardziej znaczącej dla listy \(r_1, r_2, r_3, r_4, ..., r_N\) powinien być z grubsza taki sam jak dla listy

gdzie \(B\) jest dowolną liczbą rzeczywistą.

Jeżeli wyżej wspomniana niezmienniczość mnożenia jest spełniona, rozkład cyfr na pozycji pierwszej spełnia prawo Benforda:

gdzie \(P(C_1=k)\) to względna częstość cyfry \(k\) na pierwszej pozycji (\(k = 1, ..., N-1)\), N zaś jest podstawą reprezentacji pozycyjnej liczb (standardowo \(N=10\)).

Wynik ten obrazowo uzasadnia się w następujący sposób: Jeżeli w liczbach \(r_1, r_2, r_3, r_4, ..., r_N\) przeniesiemy przecinek na miejsce po pierwszej cyfrze, otrzymamy pewien podzbiór odcinka \([1,N)\). Jeżeli każdą liczbę z tego podzbioru zlogarytmujemy, podzbiór ów przejdzie w podzbiór odcinka \([0,\log N)\), a niezmienniczość mnożenia zmieni się w niezmienniczość dodawania modulo \(\log N\). Jedyna miara prawdopodobieństwa, która spełnia niezmienniczość dodawania, to miara, która "zlogarytmowanemu" odcinkowi przypisuje prawdopodobieństwo równe jego długości podzielonej przez długość maksymalnego odcinka, czyli \(\log N\). Teraz już tylko trzeba zauważyć, że zbiór wszystkich liczb o pierwszej cyfrze \(k\) odpowiada "zlogarytmowanemu" odcinkowi \([\log k,\log(k+1))\).

Rozumowanie, które doprowadziło nas do prawa Benforda dla cyfry na pozycji pierwszej, przewiduje, że rozkłady cyfr na kolejnych pozycjach także nie są jednostajne. Odstępstwa od jednostajności dla tych pozycji są jednak znacznie słabsze.

Linki

- Benford's Law (mathworld.wolfram.com)

Jak wygrać w teleturnieju, czyli paradoks Monty'ego Halla

Według jednego z moich wykładowców na studiach pewien kongres nie-matematyków został zerwany z powodu ostrych kuluarowych kontrowersji, jakie wzbudziło prawidłowe rozwiązanie następującej zagadki:

Uczestnik-finalista pewnego teleturnieju (fama głosi, że był to "Let's Make A Deal" prowadzony przez Monty'ego Halla) staje przed trojgiem zamkniętych drzwi prowadzących do trzech różnych boksów. W jednym z boksów znajduje się drogi samochód, w każdym z pozostałych dwóch znajduje się jedna koza. Prowadzący program prosi uczestnika o wskazanie jednych drzwi. Wiadomo, że istnieją co najmniej jedne drzwi, których uczestnik nie wskazał a które prowadzą do boksu z kozą. Jedne z tych drzwi prowadzący otwiera i przy dzwiękach fanfar wyprowadza przestraszone zwierzę. Uczestnik proszony jest ponownie o wskazanie jednych z pozostałych dwóch zamkniętych drzwi - tym razem dostanie to, co kryje się za nimi. Przy założeniu, że finalista ceni sobie bardziej wygraną samochodu niż kozy, czy powinien on wskazać te same drzwi co poprzednio czy też raczej te drugie?

Prawidłowa odpowiedź brzmi: Prawdopodobieństwo tego, że samochód stoi za drzwiami wybranymi poprzednio, wynosi \(1/3\), a tego, że stoi za drugimi, wynosi \(2/3\). Korzystniej jest zatem nie obstawać przy poprzednim wyborze, lecz wskazać drzwi drugie.

Odpowiedź tę można uzyskać na kilka sposobów. Standardowy sposób, znany ze szkoły, to wypisanie listy wszystkich \(9\) możliwych par niezależnych decyzji osób przygotowujących teleturniej (\(3\) możliwości umieszczenia samochodu) oraz finalisty (\(3\) możliwości wyboru drzwi przy pierwszym wskazaniu). Wszystkie te konfiguracje decyzji wzajemnie się wykluczają, żadna nie wydaje się uprzywilejowana, a zatem rozsądnie jest przypisać każdej z nich prawdopodobieństwo \(1/9\). Jeżeli pracowicie podsumujemy prawdopodobieństwa tych konfiguracji, w których samochód kryje się za drzwiami wskazanymi pierwotnie, otrzymamy \(1/3\). Analogicznie, prawdopodobieństwo tego, że samochód stoi za drzwiami drugimi, wynosi \(2/3\).

Ładniejszy i prostszy sposób argumentacji jest następujący: Jest troje drzwi, których sposób ponumerowania jest arbitralny. Przypadkowe jest również to, za którymi drzwiami samochód stoi. Jeżeli teleturniej będzie się odbywał wielokrotnie, samochód będzie stał za drzwiami o dowolnym ustalonym numerze dokładnie w jednej trzeciej przypadków. Pierwotny wybór finalisty to właśnie ustalenie tego numeru. Niezależnie od dalszego rozwoju wypadków, w danym wydaniu teleturnieju samochód swojego położenia nie zmienia. Dlatego właśnie prawdopodobieństwo tego, że w drugiej turze finału samochód stoi za drzwiami wskazanymi pierwotnie, wynosi \(1/3\). Automatycznie prawdopodobieństwo tego, że samochód stoi gdzie indziej, czyli po prostu za drugimi nieotwartymi drzwiami, wynosi \(1 - 1/3 = 2/3\).

Linki

- The Monty Hall Page (Można zagrać samemu; dodaje poczucia własnej wartości.)

Jak ograć młodsze rodzeństwo, czyli kości Efrona

Rozważmy zbiór sześciennych kości pokrytych różnymi kombinacjami liczby oczek (od \(0\) do \(5\) na jednej ściance). Dwóch uczestników wybiera z tego zbioru po jednej kości i gra nimi przez dłuższy czas w następujący sposób. Jeżeli w danej turze uczestnik \(A\) wyrzuci swoją kością \(M\) oczek, a uczestnik \(B\) wyrzuci swoją kością \(N\) oczek, to:

- \(B\) płaci \(A\) kwotę \(M - N\) groszy, jeśli \(M \gt N\),

- \(A\) płaci \(B\) kwotę \(N - M\) groszy, jeśli \(M \lt N\),

- nikt nie płaci nikomu, gdy \(M = N\).

W takiej grze, średnie saldo uczestnika \(A\) po \(k\) turach wynosi

gdzie \(\langle D_A\rangle = \sum_M P(D_A=M)\cdot M\) to średnia liczba oczek wypadających na kości uczestnika \(A\), zaś \(\langle D_B\rangle = \sum_N P(D_B=N)\cdot N\) to średnia liczba oczek wypadających na kości uczestnika \(B\).

Zauważmy, że przedstawiona przez nas gra wprowadza w zbiorze wszystkich kości porządek liniowy:

- dla dowolnych dwóch kości \(A\), \(B\), albo kość \(A\) wygrywa z \(B\) albo \(B\) wygrywa z \(A\);

- dla dowolnych trzech kości \(A\), \(B\), \(C\), jeżeli kość \(A\) wygrywa z \(B\) a \(B\) wygrywa z \(C\), to \(A\) wygrywa także z \(C\).

Wbrew intuicji, wspomniany porządek liniowy nie będzie istnieć, jeżeli nieco zmodyfikujemy reguły gry:

- \(B\) płaci \(A\) kwotę \(1\) grosza, jeśli \(M \gt N\),

- \(A\) płaci \(B\) kwotę \(1\) grosza, jeśli \(M \lt N\),

- nikt nie płaci nikomu, gdy \(M = N\).

Tym razem wygrana zależy od znaku różnicy liczby oczek, lecz nie jest proporcjonalna do wartości bezwzględnej tej różnicy.

Można pokazać, że dla takich reguł istnieją zestawy kości \(A, B, C, D\) takie, że \(A\) wygrywa z \(B\), \(B\) wygrywa z \(C\), \(C\) wygrywa z \(D\), ...natomiast \(D\) wygrywa z \(A\). Kości takie nazywamy kośćmi Efrona (Gardner 1970). Najbardziej znany przykład to:

- \(A: 4, 4, 4, 4, 0, 0,\)

- \(B: 3, 3, 3, 3, 3, 3,\)

- \(C: 2, 2, 2, 2, 6, 6,\)

- \(D: 1, 1, 1, 5, 5, 5,\)

gdzie listy liczb to oczywiście listy liczb oczek na poszczególnych ściankach.

Linki

- Efron's Dice (mathworld.wolfram.com)

- Condorcet's method (www.wikipedia.org) — Niezupełnie na temat: Metoda Condorceta to pewna ciekawa procedura wyborcza, której główną wadą jest to, że mogą pojawić się w niej cykle przypominające cykl dla kości Efrona.

Jak nie przepłacić za rzecz bezcenną, czyli paradoks petersburski

Paradoks petersburski związany jest z następującą grą losową:

- Po wejściu do gry uczestnik wygrywa \(2^{M}\) złotych z prawdopodobieństwem \(1/2^{M}\), gdzie \(M = 1, 2, 3, ...\) .

(Taki rozkład prawdopodobieństwa nazywa się geometrycznym i można go symulować rzucając sprawiedliwą monetą tak długo, aż wypadnie orzeł. Jeżeli pierwszy orzeł wypadnie za \(M\)-tym rzutem, wypłacamy uczestnikowi \(2^{M}\) złotych.)

Pytanie: Jaka jest uczciwa opłata za możliwość przystąpienia do tej gry?

Po pierwsze doprecyzujmy, co rozumiemy przez uczciwą opłatę. Niech \(X_i\) będą wygranymi kolejnych, niezależnych od siebie partiach danej gry losowej. Oznaczmy sumy \(S_N = X_1 + X_2 + ... + X_N\) . Mówimy, że \(p\) jest uczciwą ceną jednej gry, jeżeli dla każdego \(\epsilon > 0\) prawdopodobieństwo zdarzenia \(|S_N / Np - 1| > \epsilon\) dąży do \(0\) przy \(N\) dążącym do nieskończoności.

O cenie jednej gry możemy mówić tylko wtedy, gdy wygrana w N grach jest proporcjonalna do \(N\). Wydawać by się mogło, że jeżeli wyniki w poszczególnych grach są od siebie niezależne, to wygrana w N grach musi być proporcjonalna do \(N\). Tak jednak nie jest. Uczciwa cena jednej gry istnieje dla gier o skończonej wartości oczekiwanej, tzn. gdy \(|\sum_x x \cdot P(X_i=x) | \lt \infty\). Mamy wówczas \(p = \sum_x x \cdot P(X_i=x)\).

Dla gry z paradoksu petersburskiego zachodzi \(P(X_i=x) = 1/2^{x}\), a więc \(\sum_x x \cdot P(X_i=x) = \infty\). Można także pokazać (Feller 1971), że dla każdego \(\epsilon > 0\) zachodzi zbieżnosć

W pewnym sensie można mówić zatem, że uczciwa opłata za możliwość grania w \(N\) partiach gry wynosi \(N \log_2 N\) złotych. Opłata ta rośnie szybciej niż proporcjonalnie do \(N\).

Linki

- Saint Petersburg Paradox (mathworld.wolfram.com)

Jak nie dać się uwieść symetriom, czyli problem Bertranda

Na lekcjach rachunku prawdopodobieństwa w szkole uczy się słynnej zasady Laplace'a: Jeżeli mamy \(N\) wykluczających się zdarzeń, które są jednakowo możliwe (symetryczne), to prawdopodobieństwo każdego z nich wynosi \(1/N\). Np. prawdopodobieństwo tego, że uczciwa moneta upadnie orłem do góry wynosi \(1/2\), gdyż nie ma powodu, aby któraś z dwóch stron miała wypadać częściej. Zasada jest teoretycznie bardzo piękna, jakkolwiek zrzuca wielki ciężar odpowiedzialności na nasze zmysły (czy rzeczywiście pojawia się dana symetria, czy to tylko my chcemy ją widzieć?). Inne kłopoty z zasadą Laplace'a są następujące:

- Co zrobić, jeśli w naszym problemie nie jesteśmy w stanie wyróżnić żadnego sensownego zbioru \(N\) wykluczających się "jednakowo możliwych zdarzeń"? (Np. alfabet polski liczy \(32\) litery. Czy z tego wynika, że prawdopodobieństwo dowolnego K-literowego tekstu w języku polskim wynosi \(1/32^{K}\)?)

- Co zrobić, jeżeli mamy nieskończoną liczbę "jednakowo możliwych zdarzeń"? Czy prawdopodobieństwo "\(1/\infty\)" da się jakoś zinterpretować?

Problem 1. jest beznadziejnie związany z moją pracą zawodową, a ta strona poświęcona jest rozrywce. Dlatego też przejdę od razu do problemu 2. Pojęcie nieskończonej liczby zdarzeń doprecyzowania wymaga samo. Nierównoważnych rodzajów nieskończoności matematycy wyodrębnili nieskończenie wiele. Najpopularniejsze są dwa z nich: alef-zero (tyle ile jest liczb naturalnych) oraz kontinuum (tyle ile jest liczb rzeczywistych w przedziale \([0,1]\)), przy czym kontinuum jest większe niż alef-zero.

Pojęcie "alef-zero jednakowo możliwych wykluczających się zdarzeń" jest wewnętrznie sprzeczne. Dla alef-zero wykluczających się zdarzeń ich prawdopodobieństwa muszą być nieujemne i sumować się do jedynki. Jeżeli prawdopodobieństwa te są równe i dodatnie, to ich suma jest nieskończona. Jeżeli wszystkie te prawdopodobieństwa są równe \(0\), to ich suma także wynosi \(0\).

Dla kontinuum wykluczających się zdarzeń problem definicji prawdopodobieństwa wygląda nieco inaczej. Suma kontinuum składników równych \(0\) jest nieokreślona. Aby jednoznacznie zdefiniować rozkład prawdopodobieństwa na przedziale \([0,1]\), należy przypisać prawdopodobieństwa nie tylko poszczególnym liczbom rzeczywistym, ale także pewnej klasie podzbiorów liczb rzeczywistych. (Prawdopodobieństwo podzbioru liczb rozumiemy intuicyjnie jako prawdopodobieństwo alternatywy wszystkich jego elementów.) Niestety dla niektórych rozkładów prawdopodobieństwa, istnieją także podzbiory liczb, którym nie możemy przypisać prawdopodobieństw (Billingsley 1979).

Teoria prawdopodobieństwa jest formalnie dosyć zawiła, lecz niektóre z jej rezultatów dają się intuicyjnie zrozumieć. W szczególności wiadomo, że istnieje jednostajny rozkład prawdopodobieństwa, który każdemu zdarzeniu interpretowanemu jako suma rozłącznych odcinków z przedziału \([0,1]\) przypisuje prawdopodobieństwo równe sumie długości odcinków.

Pozornie rozkład jednostajny na odcinku \([0,1]\) odpowiada naszej intuicji "kontinuum jednakowo możliwych wykluczających się zdarzeń". Tak jednak nie jest. Problem Bertranda ilustruje, że rozkład jednostajny na odcinku \([0,1]\) jest ściśle związany z reprezentacją liczb. Jeżeli liczby te będziemy interpretować jako wartości współrzędnych w pewnym probabilistycznie sformułowanym zadaniu geometrycznym, jego rozwiązanie będzie zależeć od przyjętego przez nas układu współrzędnych.

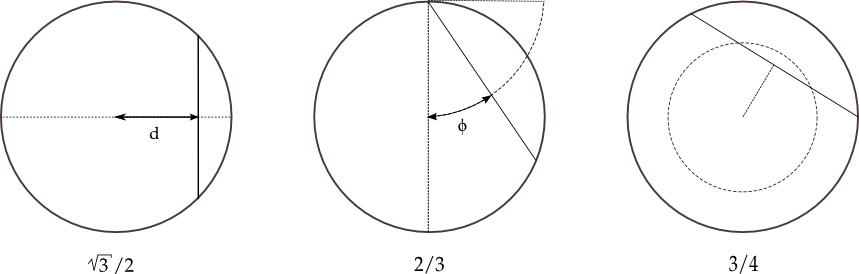

Problem Bertranda: Jakie jest prawdopodobieństwo, że przypadkowo wybrana cięciwa okręgu będzie dłuższa niż jego promień?

Odpowiedzi:

- Prawdopodobieństwo \(\sqrt{3}/2\) otrzymujemy, jeśli będziemy rozpatrywać wyłącznie cięciwy prostopadłe do pewnej średnicy i założymy jednostajny rozkład dla ich odległości od środka okręgu.

- Prawdopodobieństwo \(2/3\) otrzymujemy, jeśli będziemy rozpatrywać wyłącznie cięciwy przechodzące przez pewien punkt na okręgu i założymy jednostajny rozkład dla kąta pomiędzy cięciwą a średnicą przechodząco przez wybrany punkt.

- Prawdopodobieństwo \(3/4\) otrzymujemy z kolei, gdy będziemy losowo wybierać środek cięciwy z takiego rozkładu, że prawdopodobieństwo trafienia w pewien podzbiór punktów koła jest proporcjonalne do pola tego podzbioru.

Linki

- Bertrand's Problem (mathworld.wolfram.com)

Kiedy nie należy przejmować się tym, co myślą inni, czyli optymalna strategia zakładów

Cover i Thomas (1991) rozważają pewien prosty lecz intrygujący problem. W wyścigach konnych za \(1\) jednego dolara postawionego na konia \(k\), bukmacherzy płacą \(x_k\) dolarów, jeżeli dany koń wygra, a nie zwracają nic, jeżeli koń przegra. W każdym wyścigu wygrywa dokładnie jeden koń. W oczywisty sposób nasze zyski zależą od tego, ile bukmacherzy płacą za którego konia. Okazuje się jednak, że jeżeli gramy przez dłuższy czas, reinwestując gromadzony kapitał, to optymalna strategia obstawiania koni zależy wyłącznie od tego, z jakim prawdopodobieństwem konie wygrywają, a nie od tego, jak ich zwycięstwa wyceniają bukmacherzy.

Strategie, które bedziemy rozważać, są bardzo proste: Spośród \(W_{N-1}\) dolarów, które mamy przed \(N\)-tym wyścigiem, na każdego spośrod koni stawiamy pewien stały ułamek pieniędzy, czyli stawiamy \(b_kW_{N-1}\) dolarów na konia \(k = 1, ..., q\). Mamy \(b_k \ge 0\) oraz \(\sum_{k=1,...,q} b_k = 1\).

Niech \(k_i\) oznacza konia, który wygrał \(i\)-ty wyścig. Wówczas nasz względny przyrost kapitału wynosi \(W_N/W_0 = \prod_{i=1,...,N} b_{k_i} \cdot x_{k_i}\), co można zapisać jako

Zgodnie z prawem wielkich liczb \(\log W_N/W_0\) dąży prawie na pewno do \(N \cdot \sum_{k=1,...,q} p_k \cdot \log b_k + N \cdot \sum_{i=1,...,N} p_k \cdot \log x_k\), jeżeli w każdym wyścigu koń \(k\) ma szanse wygrania ze stałym prawdopodobieństwem \(p_k\). Nasze możliwości zmaksymalizowania zgromadzonego kapitału \(\log W_N/W_0\) ograniczają się do zmaksymalizowania składnika

Wielkość \(H(p) = - \sum_{k=1,...,q} p_k \cdot \log p_k \ge 0\) nazywa się entropią. Wielkość \(D(p || b) = - \sum_{k=1,...,q} p_k \cdot \log [b_k/p_k]\) to dywergencja Kullbacka-Leiblera. Dla \(b_k, p_k \ge 0\) oraz \(\sum_{k=1,...,q} b_k = \sum_{k=1,...,q} p_k\) zachodzi nierówność \(D(p || b) \ge 0\). Entropia \(H(p)\) jest dodatnia wtedy i tylko wtedy, gdy wśród koni nie ma takiego, który wygrywałby z prawdopodobieństwem \(1\). Dywergencja \(D(p || b)\) jest dodatnia wtedy i tylko wtedy, gdy \(b_k \ne p_k\).

Optymalna strategia zakładów to taka, w której na konia k stawiamy kapitał proporcjonalny do prawdopodobieństwa jego wygranej,

Wówczas \(D(p || b) = 0\). Strategia ta nie zależy od tego, ile bukmacherzy płacą za zwycięstwa poszczególnych koni. Niestety, nawet przy najlepszej możliwej strategii w \(N\) wyścigach nie jesteśmy w stanie uzyskać średnio więcej niż \(\exp ( - [ 2 H(p) + D(p || x) ] N )\) dolarów z jednego dolara zainwestowanego na początku. Możemy się spodziewać, że prawdziwi bukmacherzy zrobią wszystko, aby utrzymać nierówność \(D(p || x) > - 2 H(p)\) na poziomie gwarantującym im rozsądne zyski. Czy zatem warto jest grać na wyścigach i dociekać, który koń z jakim prawdopodobieństwem wygrywa naprawdę?

W powyższym problemie urzeka mnie myśl, że na dłuższą metę instytucja procentu składanego (systematycznego reinwestowania zysków) premiuje inwestowanie w konkurencyjne przedsięwzięcia ("konie") w stopniu proporcjonalnym do ich obiektywnej szansy powodzenia niezależnie od tego, jakie poglądy na temat ich wartości usiłują przeforsować instytucje finansowe ("bukmacherzy" mogący tworzyć pieniądz i udzielać preferencyjnych kredytów). Jedynym warunkiem jest to, aby instytucje finansowe pozwalały inwestorom średnio rzecz biorąc pomnażać kapitał.

Literatura

- Billingsley, P. (1979). "Probability and Measure". J. Wiley.

- Benford, F. (1938). "The Law of Anomalous Numbers". Proc. Amer. Phil. Soc. 78, pp. 551−572.

- Cover, T. M., Thomas J. A. (1991). "Elements of Information Theory". J. Wiley.

- Feller, W. (1971). "An Introduction to Probability Theory and Its Applications", 3rd ed. J. Wiley. (wybrane rozdziały: vol. 1, §10.4 The Petersburg Game; vol. 2, §6.12 Martingales)

- Gardner, M. (1970). "Mathematical Games: The Paradox of the Nontransitive Dice and the Elusive Principle of Indifference". Scientific American 223 (December), pp. 110−114.

- von Mises, R. (1919). "Fundamentalsätzen der Wahrscheinlichkeitsrehnung". Mathematische Zeitschriften 5, pp. 52−99.